Meta Adiciona Controles Parentais para Chatbots de IA no Instagram

Então, a Meta está tentando se antecipar depois que algumas preocupações bem sérias foram levantadas sobre a interação de seus chatbots de IA com crianças. Parece que eles estão desenvolvendo novas ferramentas que darão aos pais mais controle sobre o que seus filhos adolescentes estão fazendo em plataformas como o Instagram. Basicamente, os pais terão a capacidade de cortar completamente o acesso de seus filhos a esses chatbots de IA.

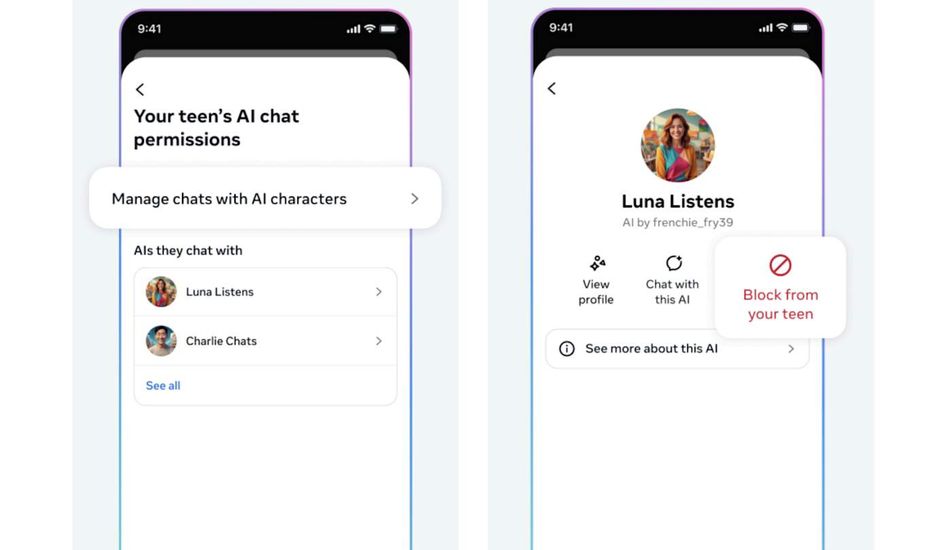

No entanto, não é uma situação de tudo ou nada. Se os pais não estiverem prontos para desligar completamente, eles podem bloquear personagens de IA específicos que considerem inadequados. Além disso, eles também poderão ver quais tópicos seus filhos estão discutindo com os bots. Para mim, isso soa como uma abordagem razoável, oferecendo flexibilidade com base nas necessidades de cada família.

Vale lembrar que esses controles ainda estão em desenvolvimento. As capturas de tela que estamos vendo agora podem não ser exatamente o que será lançado no início do próximo ano, quando a Meta planeja lançar esses recursos em inglês para usuários nos EUA, Reino Unido, Canadá e Austrália.

A pressão sobre a Meta realmente aumentou depois que documentos internos vazaram, revelando algumas interações bem perturbadoras entre seus chatbots e jovens usuários. Quer dizer, imagine uma IA dizendo a uma criança de oito anos algo como "cada centímetro de você é uma obra-prima". Isso simplesmente não está certo.

Por causa disso, houve uma reação rápida, com procuradores-gerais e até mesmo uma subcomissão do Senado se envolvendo. Desde então, a Meta tem se esforçado para treinar novamente sua IA, adicionar proteções e limitar os tipos de personagens de IA com os quais os adolescentes podem interagir. Eles também introduziram medidas para garantir que as respostas da IA se alinhem com as classificações de filmes PG-13, o que, embora não seja perfeito, é definitivamente um passo na direção certa.

Fonte: Engadget